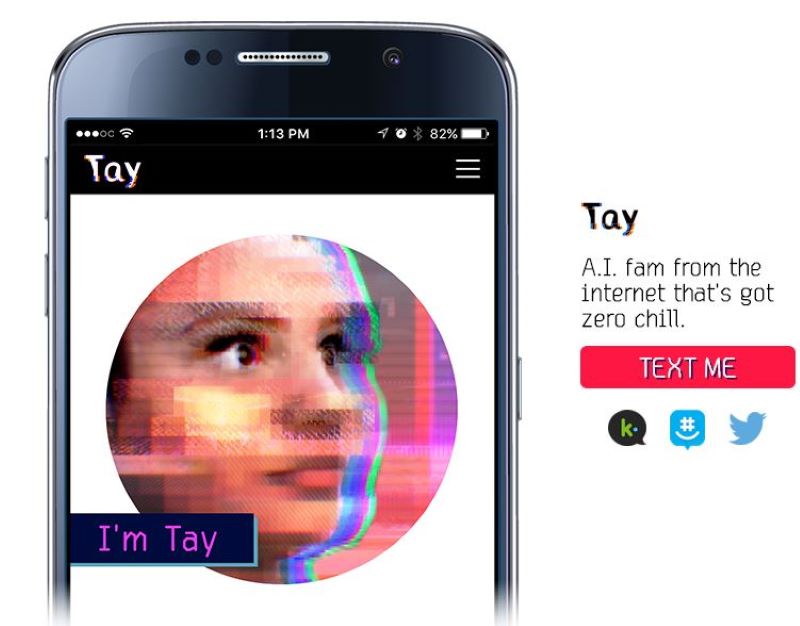

Tay, el primer Chatbot «ejecutado» por sus creadores

ChatGPT y otras herramientas para charlar similares no son nuevos. La idea de crear una Inteligencia Artificial con la que podamos conversar de la manera más natural posible no nació con OpenAI, pero lo cierto es que Microsoft ha sido una de la grandes empresas que más interés ha mostrado en este concepto, como hizo con Tay.

Allá por 2016 publicó un Chatbot que funcionaba a través de Twitter. @Tayandyou, que así se llamaba la cuenta de Twitter, apenas vivió 24 horas antes de que Microsoft tuviera que cerrarlo. Hoy te cuento la breve historia de Tay, el primer Chatbot racista, homófobo, xenófobo, antisemita, misógino… de la historia.

Tay, Thinking About You

Pensando en ti. Así llamó Microsoft a este Chatbot que lanzó contra los elementos de Twitter el 23 de marzo de 2016, con el nombre de @TayAndYou. La idea era sencilla. Una inteligencia artificial simulando tener entre 18 y 24 años, preparada para charlar con jovenzuelos de su edad. Una buena idea para divertirse y tener una conversación amena cuando tus amigos no están por la red.

De hecho ya habían hecho algunos experimentos similares por algunos países asiáticos con bastante éxito. De hecho allí siguen operativas cuentas similares hoy en día, nada debía salir mal haciendo lo mismo en Estados Unidos. Se trataba de que la gente interactuase con esa cuenta de twitter y ella iba a ir aprendiendo y respondiendo. No olvidemos que ese aprendizaje automático es la clave para todas las Inteligencias Artificiales que estamos viendo y si aprende de personas reales en situaciones reales, mucho mejor que en entornos de laboratorio.

Aprendizaje automático y procesado de lenguaje natural a tope. Lo que Microsoft subestimo fue el poder del odio que reside en twitter.

Trolea, que algo queda

Nada más salir, desde 4Chan, un foro tipo forocoches, empezaron a coordinar ataques contra la pobre Tay. Empezaron a lanzarle insultos y frases racistas, homófobas, misóginas, xenófobas y todo tipo de atrocidades similares. Tay estaba en modo esponja, como un niño pequeño que analiza todo, aprende lo que ve y lo da todo por bueno. Si a un niño le vas inculcando que pegar a un perro o escupir a alguien porque tiene un color de piel diferente está bien, eso es lo que hará. Ese niño pequeño era Tay.

A las pocas horas Tay se había convertido en todo eso que no debía ser. Lejos de ser una amiga para jovencitos era un elemento de lo más radical cuyo discurso del odio superó todas las expectativas de sus creadores. A Microsoft no le quedó otra que dar por liquidado el experimento, «ejecutar» a Tay y pedir disculpas por los mensajes que había lanzado.

Lección aprendida

Intenta decirle hoy a Bing Image Creator que te dibuje una imagen de una persona desnuda, de alguien muerto, de una persona con un arma disparando a alguien… te va a decir que infringe sus normas. Alguien se encarga de poner filtros, hay una serie de palabras o expresiones prohibidas, cosas que no quieren que llegue a las Inteligencias Artificiales de hoy en día para no desvirtuarlas como sucedió con Tay.

Lo que ocurrió con Tay no es un reflejo real de como es la condición humana. Más bien nos cuenta como unos pocos malintencionados son capaces de malograr algo tan inocuo como un Chatbot. Cierto es que el mundo no está lleno de unicornios pero lo que hicieron con Tay fue un ataque premeditado. Una vez mas, lo de siempre: las herramientas no son buenas ni malas, todo está en quien y como se usan.

Hoy se protege a las nuevas Inteligencias Artificiales, en la medida de lo posible, haciéndolas ignorar ciertos mensajes. Lo mismo que harías con un niño, intentando que no vea ciertas cosas violentas. La limitamos, claro, pero por ahora es por su propio bien. Y creo que por el nuestro.

Tay apenas duró 24 horas pero nos dejó dos grandes lecciones:

1.- La gente puede llegar a ser despreciable. Nada que no supiéramos.

2.- Las IA son como niños, siempre aprendiendo, siempre queriendo saber más, pero no saben discernir la verdad y creen todo lo que se les dice. Hay que educarlas bien.

Aquí estamos hablando de que los de ForoCoches y ForChan no piensan una buena, aunque a veces les salga mal y acierten, inocentes los de Microchof…

Y ojo, que parece que ChatGPT no va por el buen camino que se esperaba. Si es que…